發生什麼事?

ChatGPT 為美國公司 OpenAI 於 2022 年 11 月推出的聊天機器人,推出五天內即累積一百萬用戶,以真人的口吻與使用者對話、完成各種任務,如寫程式碼、節目腳本、文章、歌詞、廣告文案等。(Insider)

- OpenAI 於 2015 年成立,致力於研究通用人工智慧(Artificial General Intelligence,AGI),希望建立出高度自治、比人類優化的系統,旗下有文字生成圖像的 DALL·E 2、將語音轉譯為文本的 Whisper 等系統。(OpenAI)

- 2018 年 OpenAI 釋出 Generative Pre-trained Transformer(GPT,生成式預先訓練變換器)的概念,受到人腦結構與功能所啟發,此機器學習模型用大量的人類生成文本訓練而成。(Taskade)

- OpenAI 團隊使用 1.17 億個參數,訓練出第一個模型 GPT-1,而後用八百萬個網頁、15 億個參數訓練,演變成 GPT-2,可聊天、閱讀摘要等。(數位時代)

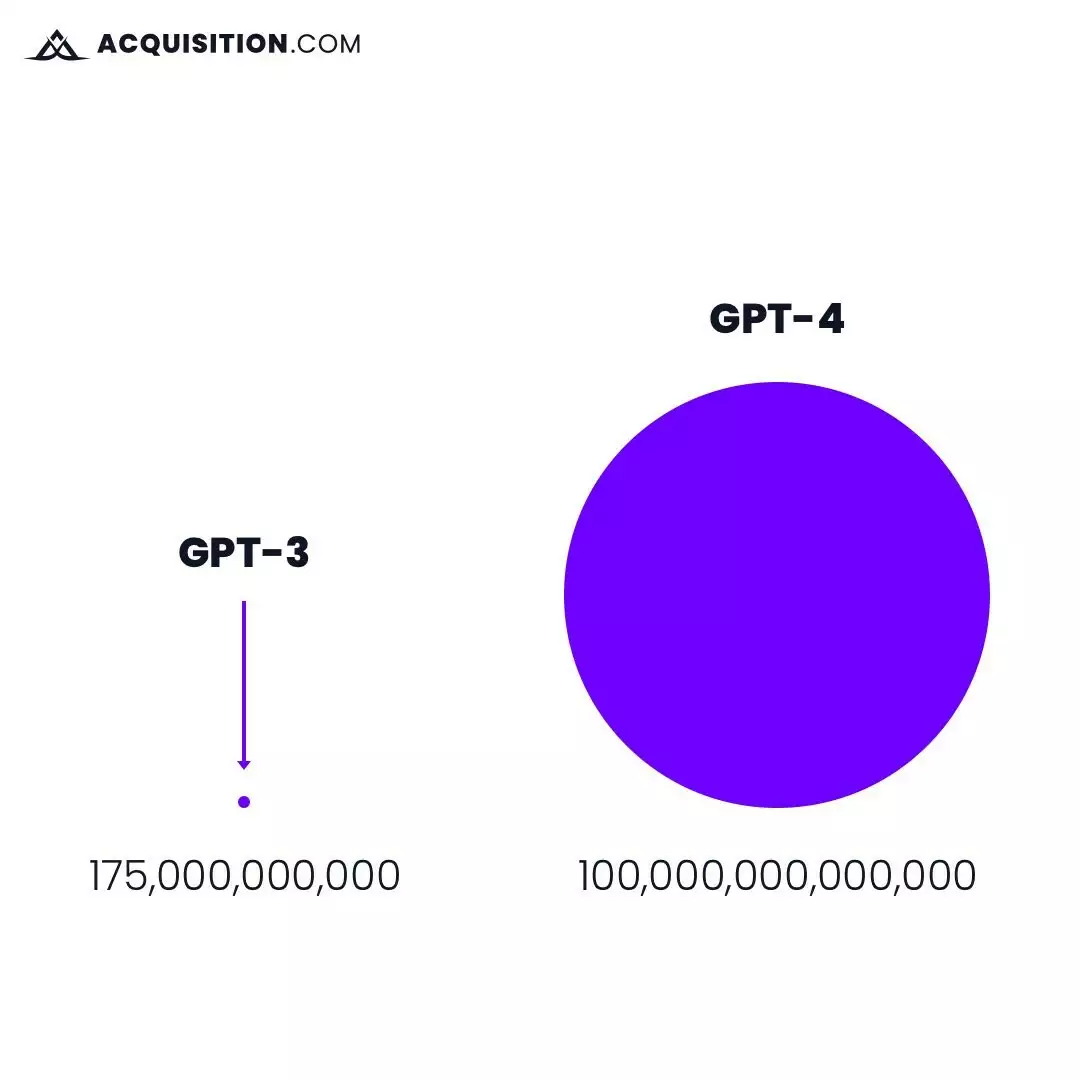

- 因訓練規模、數據運力增加,微軟在 2019 年投入 10 億美金並提供運算資源。GPT-3 於 2020 年推出,使用 1,750 億個參數,可理解上下文並依照對話內容調整答案。GPT-4 正在研發中,外界推測將用 100 萬億個參數訓練,能力將更上一階。

GPT-4 將會使用比 GPT-3 大上好幾倍的參數資料。(圖片來源:OpenAI)

GPT-4 將會使用比 GPT-3 大上好幾倍的參數資料。(圖片來源:OpenAI)

GPT 是如何被訓練的?

- 台大電機工程學系副教授李宏毅分析,其訓練模組可分為四個階段。(INSIDE)

- 學習文字接龍:在大量文本的學習下,GPT 知道特定字詞後該如何接龍,以生成完整句子,例如「你好」後面,GPT 會接上「美」,生成「你好美」的句子,但因可能性多樣,每次輸出結果都會不同。

- 人類引導文字接龍方向:藉由人工給出答案、人力標注出「好的對話內容」,讓 GPT 學習何謂「有用的答案」。

- 模仿人類喜好:訓練出另一組 AI「老師模型」,此模型以人類的評分標準,對 GPT 的答案評分,用分數高低讓其了解人類偏好的回覆。

- 用增強式學習向模擬老師學習:GPT 不斷生成答案並丟給「老師模型」得到分數,若較為低分會調整參數,試圖達到高分。

- 網友利用回饋強化學習的功能,要求 ChatGPT 叫自己「寶寶」,並在收到回應後要説「寶寶在這裡」,成功將其「訓練」為虛擬男友。

ChatGPT 的應用?

雖 ChatGPT 能力佳、應用廣,但若未給予精確的指令,仍無法生成最佳答案,因此坊間出現各種「ChatGPT 咒語大全、指令大全」,幫助使用者準確與之溝通。

- 軟體工程師開發出「ChatGPT 指令大全」,分成寫報告、準備面試、程式開發、履歷與自傳等使用情境,使用者只要複製文字並稍作修改,就能引導系統給出精準結果。(ExplainThis)

- 舉例來說,若要「撰寫標題」,可複製此指令並加以修改:「寫出(數字)個有關(主題)的(社群平台)風格標題,要遵守以下規則:(規則 1、規則 2、...)」。

- 參考範例為「寫出 5 個有關日本迪士尼旅遊心得的 Instagram 風格標題,要遵守以下規則:標題不超過 20 字、標題要加上適當表情符號」。

人工智慧發展下,有人拭目以待、有人恐懼自己的工作被取代,我們該如何看待 ChatGPT 的出現?透過台大資工系副教授陳縕儂的訪談,來了解 ChatGPT 的開發歷程、特殊性,並學習如何更有效、更精準的使用此工具。